Projet EXPLAINER

EXPLAINER : RÉVÉLER LA PARTIE CACHÉE DES ARGUMENTS

EXPLAINER : RÉVÉLER LA PARTIE CACHÉE DES ARGUMENTS

A propos du projet

Lorsqu’on argumente, on n’énonce pas toujours toutes les étapes de son raisonnement. Certaines restent implicites, fondées sur des connaissances ou croyances supposées partagées. Un enthymème est précisément un argument incomplet, dans lequel une prémisse ou une conclusion est laissée sous-entendue. Les humains recourent spontanément à ce procédé, mais pour les méthodes d’intelligence artificielle, il constitue un défi majeur.

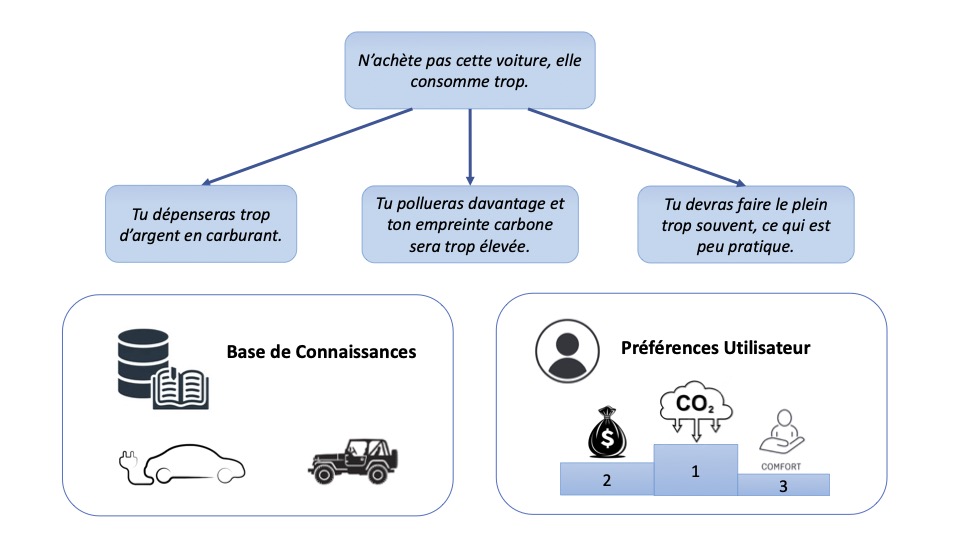

Prenons un exemple. Quelqu’un affirme : « N’achète pas cette voiture, elle consomme trop. » L’argument paraît clair, mais reste ambigu : trop en termes de quoi ? Plusieurs décodages sont possibles :

« Tu dépenseras trop d’argent en carburant. »

« Tu pollueras davantage et ton empreinte carbone sera trop élevée. »

« Tu devras faire le plein trop souvent, ce qui est peu pratique. »

Sans explicitation, il est difficile de savoir quel raisonnement est réellement avancé. L’enthymème laisse donc une zone d’incertitude que le décodage cherche à élucider.

Les approches actuelles en intelligence artificielle peuvent générer des arguments ou simuler des débats. Mais elles rencontrent des difficultés dès qu’il s’agit de gérer l’implicite : elles ignorent souvent des hypothèses essentielles ou, au contraire, en inventent d’infondées. Leurs résultats perdent alors en fiabilité, en transparence et en crédibilité.

Le projet EXPLAINER, un postdoctorat d’un an soutenu par l’Académie RISE et mené par Victor David en collaboration avec Anthony Hunter et Serena Villata, a pour objectif de développer des méthodes de décodage des enthymèmes : rendre visibles les parties implicites du raisonnement et évaluer la qualité des reconstructions produites.

Un axe central sera la constitution d’un jeu de données de débats, conçu pour inclure des catégories ciblées d’enthymèmes. Les formes rationnelles ou de sens commun représentent déjà un défi majeur à analyser, tandis que les plus complexes (e.g. liées à la psychologie ou au comportement humain) seront laissées à de futurs travaux. Ces débats seront définis de manière contrôlée afin de refléter ces difficultés, offrant un terrain solide pour explorer différentes façons de compléter l’implicite et comparer la qualité des décodages.

Au-delà de ce jeu de données, EXPLAINER développera des méthodes pour reconstituer les étapes manquantes du raisonnement et déterminer si les reconstructions sont précises, cohérentes et utiles.

Pourquoi est-ce crucial ? Parce que les enthymèmes sont omniprésents : dans les débats politiques, les raisonnements juridiques, les discussions quotidiennes ou les échanges en ligne. Pour que les méthodes d’IA participent de manière pertinente à ces contextes, elles doivent apprendre non seulement à produire des arguments, mais aussi à rendre explicite ce que les humains laissent implicite. C’est ainsi que le raisonnement devient véritablement compréhensible et vérifiable.

En relevant ce défi, EXPLAINER posera les bases d’une IA qui ne se contente pas de générer du texte, mais qui explique son raisonnement. Avec un jeu de données de référence et une méthodologie innovante pour traiter l’implicite, ce projet entend faire un pas vers une intelligence artificielle plus transparente et fiable.

- Chercheur principal

- Victor David (Inria, i3S)

- Partenaires projet

-

- Anthony Hunter (UCL)

- Serena Villata (CNRS,i3S)

- Durée

- 12 mois

- Montant total

- 60k€